前文介绍了MySQL的安装和配置过程,本文记录将股票数据写入到MySQL的过程。

安装pymysql

使用python实现与MySQL的数据读写时,需要安装相关的包。由于我们搭建开发环境时选择的是Anaconda,大部分包已经被默认安装好,这里只需要手动安装pymysql:

pip install pymysql

主要代码分析

新建源文件,命名为data_center_v7.py,全部内容见文末,v7主要涉及2个方面改动:

新增创建数据库引擎对象函数

def create_mysql_engine():

该函数用于创建数据库引擎对象,返回值为新创建的数据库引擎对象。

host = 'localhost'

user = 'root'

passwd = '111111'

port = '3306'

db = 'db_quant'

定义引擎参数信息。

mysql_engine = sqlalchemy.create_engine(

'mysql+pymysql://{0}:{1}@{2}:{3}'.format(user, passwd, host, port),

poolclass=sqlalchemy.pool.NullPool

)

创建数据库引擎对象,用于后面判断是否需要创建数据库。

mysql_engine.execute("CREATE DATABASE IF NOT EXISTS {0} ".format(db))

如果不存在数据库db_quant则创建。

db_engine = sqlalchemy.create_engine(

'mysql+pymysql://{0}:{1}@{2}:{3}/{4}?charset=utf8'.format(user, passwd, host, port, db),

poolclass=sqlalchemy.pool.NullPool

)

创建连接数据库db_quant的引擎对象。

return db_engine

返回引擎对象。

修改创建数据函数

def create_data(stock_codes, from_date='1990-12-19', to_date=datetime.date.today().strftime('%Y-%m-%d'),

adjustflag='2'):

"""

下载指定日期内,指定股票的日线数据,计算扩展因子

:param stock_codes: 待下载数据的股票代码

:param from_date: 日线开始日期

:param to_date: 日线结束日期

:param adjustflag: 复权选项 1:后复权 2:前复权 3:不复权 默认为前复权

:return: None

"""

# 创建数据库引擎对象

engine = create_mysql_engine()

这里创建数据库引擎对象,用于后续将数据写入数据库。

# 下载股票循环

for code in stock_codes:

print('正在下载{}...'.format(code))

# 登录BaoStock

bs.login()

# 下载日线数据

out_df = bs.query_history_k_data_plus(code, g_baostock_data_fields, start_date=from_date, end_date=to_date,

frequency='d', adjustflag=adjustflag).get_data()

# 剔除停盘数据

if out_df.shape[0]:

out_df = out_df[(out_df['volume'] != '0') & (out_df['volume'] != '')]

# 如果数据为空,则不创建

if not out_df.shape[0]:

continue

# 删除重复数据

out_df.drop_duplicates(['date'], inplace=True)

# 日线数据少于g_available_days_limit,则不创建

if out_df.shape[0] < g_available_days_limit:

continue

# 将数值数据转为float型,便于后续处理

convert_list = ['open', 'high', 'low', 'close', 'preclose', 'volume', 'amount', 'turn', 'pctChg']

out_df[convert_list] = out_df[convert_list].astype(float)

# 重置索引

out_df.reset_index(drop=True, inplace=True)

# 计算扩展因子

out_df = extend_factor(out_df)

以上内容与v3相同,可参考v3分析内容。

# 写入数据库

table_name = '{}_{}'.format(code[3:], code[:2])

out_df.to_sql(name=table_name, con=engine, if_exists='replace', index=True, index_label='id')

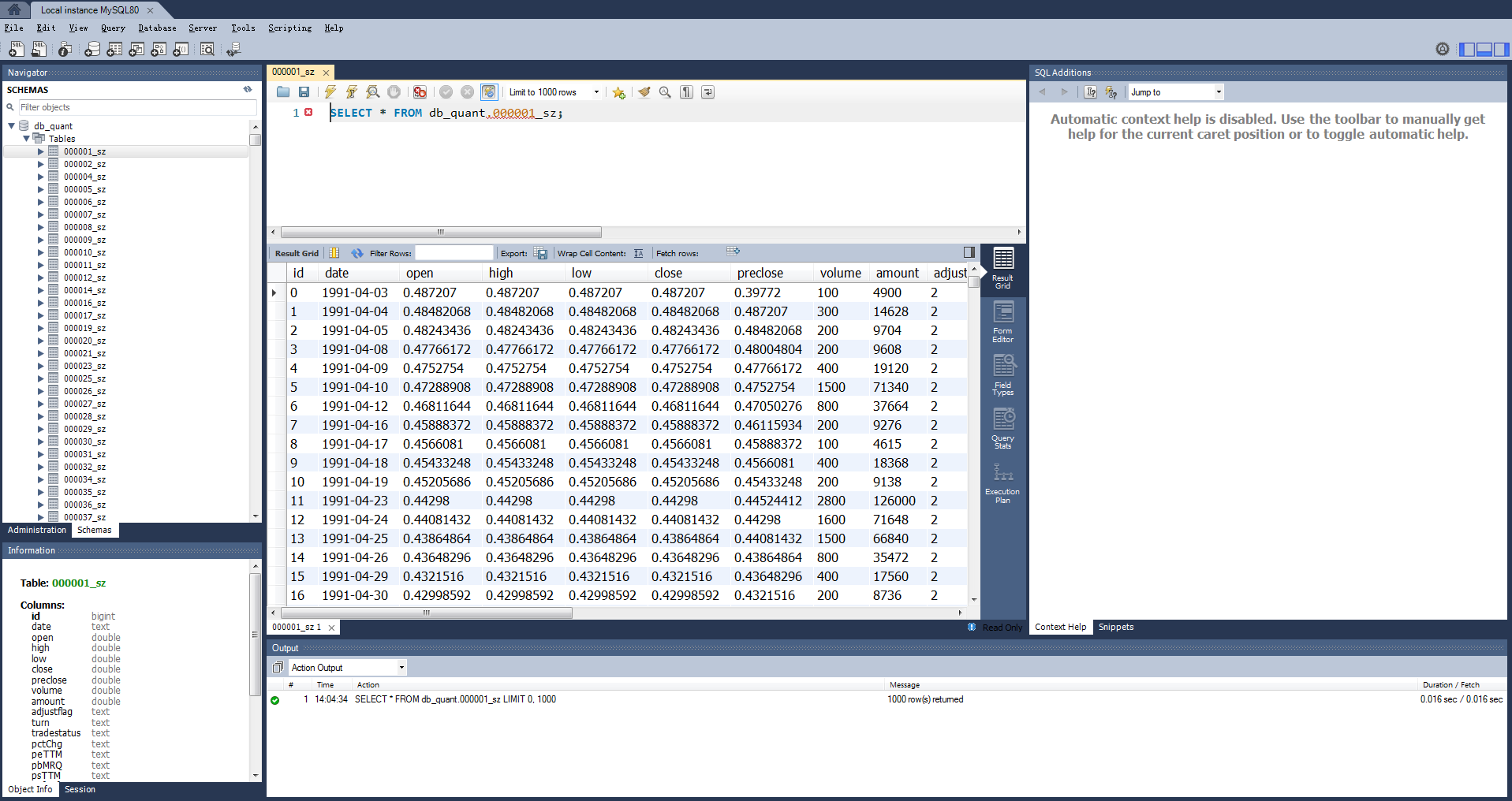

使用DataFrame的to_sql方法,将数据写入MySQL。这里每只股票的数据会形成一张表,表名的格式为“代码_市场”,例如股票sh.600158中体产业的数据,会保存在600158_sh中。

查看写入数据结果

打开MySQL Workbench,点击左侧Local instance MySQL80位置,如下图所示:

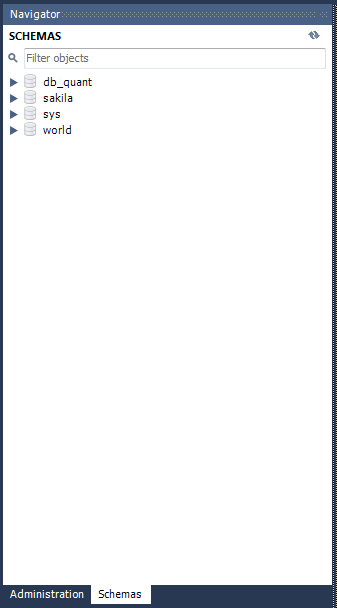

第一次登录需要输入密码,登录后就可以查看本机数据库内容,导航窗口的Schemas标签内容如下:

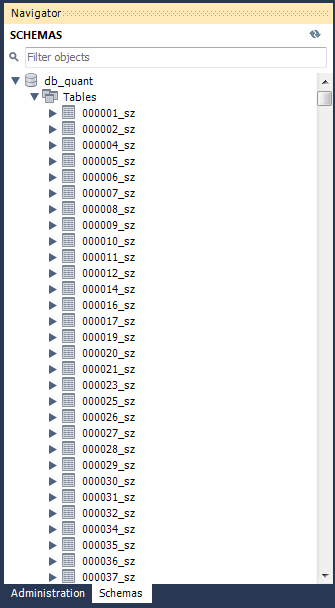

可以看到MySQL中包含了我们创建db_quant数据库,点击db_quant左侧下拉三角,再点击其下方Table左侧的下拉三角,就可以看到我们创建的所有股票的表:

我们可以右键点击任意一张表,然后选择Select Rows – Limit 1000,就可以查看具体的数据内容:

要查看更多数据内容或者操作数据,就可以脚本窗口编写SQL语句,执行相关的操作。

小结

至此,我们完成了股票数据的创建,并把数据写入到MySQL中。

下一篇文章将记录从MySQL中读取数据的过程。

data_center_v7.py的全部代码如下:

import baostock as bs

import datetime

import sys

import numpy as np

import pandas as pd

import multiprocessing

import sqlalchemy

# 可用日线数量约束

g_available_days_limit = 250

# BaoStock日线数据字段

g_baostock_data_fields = 'date,open,high,low,close,preclose,volume,amount,adjustflag,turn,tradestatus,pctChg,peTTM,pbMRQ, psTTM,pcfNcfTTM,isST'

def create_mysql_engine():

"""

创建数据库引擎对象

:return: 新创建的数据库引擎对象

"""

# 引擎参数信息

host = 'localhost'

user = 'root'

passwd = '111111'

port = '3306'

db = 'db_quant'

# 创建数据库引擎对象

mysql_engine = sqlalchemy.create_engine(

'mysql+pymysql://{0}:{1}@{2}:{3}'.format(user, passwd, host, port),

poolclass=sqlalchemy.pool.NullPool

)

# 如果不存在数据库db_quant则创建

mysql_engine.execute("CREATE DATABASE IF NOT EXISTS {0} ".format(db))

# 创建连接数据库db_quant的引擎对象

db_engine = sqlalchemy.create_engine(

'mysql+pymysql://{0}:{1}@{2}:{3}/{4}?charset=utf8'.format(user, passwd, host, port, db),

poolclass=sqlalchemy.pool.NullPool

)

# 返回引擎对象

return db_engine

def get_stock_codes(date=None):

"""

获取指定日期的A股代码列表

若参数date为空,则返回最近1个交易日的A股代码列表

若参数date不为空,且为交易日,则返回date当日的A股代码列表

若参数date不为空,但不为交易日,则打印提示非交易日信息,程序退出

:param date: 日期

:return: A股代码的列表

"""

# 登录baostock

bs.login()

# 从BaoStock查询股票数据

stock_df = bs.query_all_stock(date).get_data()

# 如果获取数据长度为0,表示日期date非交易日

if 0 == len(stock_df):

# 如果设置了参数date,则打印信息提示date为非交易日

if date is not None:

print('当前选择日期为非交易日或尚无交易数据,请设置date为历史某交易日日期')

sys.exit(0)

# 未设置参数date,则向历史查找最近的交易日,当获取股票数据长度非0时,即找到最近交易日

delta = 1

while 0 == len(stock_df):

stock_df = bs.query_all_stock(datetime.date.today() - datetime.timedelta(days=delta)).get_data()

delta += 1

# 注销登录

bs.logout()

# 筛选股票数据,上证和深证股票代码在sh.600000与sz.39900之间

stock_df = stock_df[(stock_df['code'] >= 'sh.600000') & (stock_df['code'] < 'sz.399000')]

# 返回股票列表

return stock_df['code'].tolist()

def create_data(stock_codes, from_date='1990-12-19', to_date=datetime.date.today().strftime('%Y-%m-%d'),

adjustflag='2'):

"""

下载指定日期内,指定股票的日线数据,计算扩展因子

:param stock_codes: 待下载数据的股票代码

:param from_date: 日线开始日期

:param to_date: 日线结束日期

:param adjustflag: 复权选项 1:后复权 2:前复权 3:不复权 默认为前复权

:return: None

"""

# 创建数据库引擎对象

engine = create_mysql_engine()

# 下载股票循环

for code in stock_codes:

print('正在下载{}...'.format(code))

# 登录BaoStock

bs.login()

# 下载日线数据

out_df = bs.query_history_k_data_plus(code, g_baostock_data_fields, start_date=from_date, end_date=to_date,

frequency='d', adjustflag=adjustflag).get_data()

# 剔除停盘数据

if out_df.shape[0]:

out_df = out_df[(out_df['volume'] != '0') & (out_df['volume'] != '')]

# 如果数据为空,则不创建

if not out_df.shape[0]:

continue

# 删除重复数据

out_df.drop_duplicates(['date'], inplace=True)

# 日线数据少于g_available_days_limit,则不创建

if out_df.shape[0] < g_available_days_limit:

continue

# 将数值数据转为float型,便于后续处理

convert_list = ['open', 'high', 'low', 'close', 'preclose', 'volume', 'amount', 'turn', 'pctChg']

out_df[convert_list] = out_df[convert_list].astype(float)

# 重置索引

out_df.reset_index(drop=True, inplace=True)

# 计算扩展因子

out_df = extend_factor(out_df)

# 写入数据库

table_name = '{}_{}'.format(code[3:], code[:2])

out_df.to_sql(name=table_name, con=engine, if_exists='replace', index=True, index_label='id')

def get_code_group(process_num, stock_codes):

"""

获取代码分组,用于多进程计算,每个进程处理一组股票

:param process_num: 进程数

:param stock_codes: 待处理的股票代码

:return: 分组后的股票代码列表,列表的每个元素为一组股票代码的列表

"""

# 创建空的分组

code_group = [[] for i in range(process_num)]

# 按余数为每个分组分配股票

for index, code in enumerate(stock_codes):

code_group[index % process_num].append(code)

return code_group

def multiprocessing_func(func, args):

"""

多进程调用函数

:param func: 函数名

:param args: func的参数,类型为元组,第0个元素为进程数,第1个元素为股票代码列表

:return: 包含各子进程返回对象的列表

"""

# 用于保存各子进程返回对象的列表

results = []

# 创建进程池

with multiprocessing.Pool(processes=args[0]) as pool:

# 多进程异步计算

for codes in get_code_group(args[0], args[1]):

results.append(pool.apply_async(func, args=(codes, *args[2:],)))

# 阻止后续任务提交到进程池

pool.close()

# 等待所有进程结束

pool.join()

return results

def create_data_mp(stock_codes, process_num=61,

from_date='1990-12-19', to_date=datetime.date.today().strftime('%Y-%m-%d'), adjustflag='2'):

"""

使用多进程创建指定日期内,指定股票的日线数据,计算扩展因子

:param stock_codes: 待创建数据的股票代码

:param process_num: 进程数

:param from_date: 日线开始日期

:param to_date: 日线结束日期

:param adjustflag: 复权选项 1:后复权 2:前复权 3:不复权 默认为前复权

:return: None

"""

multiprocessing_func(create_data, (process_num, stock_codes, from_date, to_date, adjustflag,))

def extend_factor(df):

"""

计算扩展因子

:param df: 待计算扩展因子的DataFrame

:return: 包含扩展因子的DataFrame

"""

# 使用pipe依次计算涨停、双神及是否为候选股票

df = df.pipe(zt).pipe(ss, delta_days=30).pipe(candidate)

return df

def zt(df):

"""

计算涨停因子

若涨停,则因子为True,否则为False

以当日收盘价较前一日收盘价上涨9.8%及以上作为涨停判断标准

:param df: 待计算扩展因子的DataFrame

:return: 包含扩展因子的DataFrame

"""

df['zt'] = np.where((df['close'].values >= 1.098 * df['preclose'].values), True, False)

return df

def shift_i(df, factor_list, i, fill_value=0, suffix='a'):

"""

计算移动因子,用于获取前i日或者后i日的因子

:param df: 待计算扩展因子的DataFrame

:param factor_list: 待移动的因子列表

:param i: 移动的步数

:param fill_value: 用于填充NA的值,默认为0

:param suffix: 值为a(ago)时表示移动获得历史数据,用于计算指标;值为l(later)时表示获得未来数据,用于计算收益

:return: 包含扩展因子的DataFrame

"""

# 选取需要shift的列构成新的DataFrame,进行shift操作

shift_df = df[factor_list].shift(i, fill_value=fill_value)

# 对新的DataFrame列进行重命名

shift_df.rename(columns={x: '{}_{}{}'.format(x, i, suffix) for x in factor_list}, inplace=True)

# 将重命名后的DataFrame合并到原始DataFrame中

df = pd.concat([df, shift_df], axis=1)

return df

def shift_till_n(df, factor_list, n, fill_value=0, suffix='a'):

"""

计算范围移动因子

用于获取前/后n日内的相关因子,内部调用了shift_i

:param df: 待计算扩展因子的DataFrame

:param factor_list: 待移动的因子列表

:param n: 移动的步数范围

:param fill_value: 用于填充NA的值,默认为0

:param suffix: 值为a(ago)时表示移动获得历史数据,用于计算指标;值为l(later)时表示获得未来数据,用于计算收益

:return: 包含扩展因子的DataFrame

"""

for i in range(n):

df = shift_i(df, factor_list, i + 1, fill_value, suffix)

return df

def ss(df, delta_days=30):

"""

计算双神因子,即间隔的两个涨停

若当日形成双神,则因子为True,否则为False

:param df: 待计算扩展因子的DataFrame

:param delta_days: 两根涨停间隔的时间不能超过该值,否则不判定为双神,默认值为30

:return: 包含扩展因子的DataFrame

"""

# 移动涨停因子,求取近delta_days天内的涨停情况,保存在一个临时DataFrame中

temp_df = shift_till_n(df, ['zt'], delta_days, fill_value=False)

# 生成列表,用于后续检索第2天前至第delta_days天前是否有涨停出现

col_list = ['zt_{}a'.format(x) for x in range(2, delta_days + 1)]

# 计算双神,需同时满足3个条件:

# 1、第2天前至第delta_days天前,至少有1个涨停

# 2、1天前不是涨停(否则就是连续涨停,不是间隔的涨停)

# 3、当天是涨停

df['ss'] = temp_df[col_list].any(axis=1) & ~temp_df['zt_1a'] & temp_df['zt']

return df

def ma(df, n=5, factor='close'):

"""

计算均线因子

:param df: 待计算扩展因子的DataFrame

:param n: 待计算均线的周期,默认计算5日均线

:param factor: 待计算均线的因子,默认为收盘价

:return: 包含扩展因子的DataFrame

"""

# 均线名称,例如,收盘价的5日均线名称为ma_5,成交量的5日均线名称为volume_ma_5

name = '{}ma_{}'.format('' if 'close' == factor else factor + '_', n)

# 取待计算均线的因子列

s = pd.Series(df[factor], name=name, index=df.index)

# 利用rolling和mean计算均线数据

s = s.rolling(center=False, window=n).mean()

# 将均线数据添加到原始的DataFrame中

df = df.join(s)

# 均线数值保留两位小数

df[name] = df[name].apply(lambda x: round(x + 0.001, 2))

return df

def mas(df, ma_list, factor='close'):

"""

计算多条均线因子,内部调用ma计算单条均线

:param df: 待计算扩展因子的DataFrame

:param ma_list: 待计算均线的周期列表

:param factor: 待计算均线的因子,默认为收盘价

:return: 包含扩展因子的DataFrame

"""

for i in ma_list:

df = ma(df, i, factor)

return df

def cross_mas(df, ma_list):

"""

计算穿均线因子

若当日最低价不高于均线价格

且当日收盘价不低于均线价格

则当日穿均线因子值为True,否则为False

:param df: 待计算扩展因子的DataFrame

:param ma_list: 均线的周期列表

:return: 包含扩展因子的DataFrame

"""

for i in ma_list:

df['cross_{}'.format(i)] = (df['low'] <= df['ma_{}'.format(i)]) & (

df['ma_{}'.format(i)] <= df['close'])

return df

def candidate(df):

"""

计算是否为候选

若当日日线同时穿过5、10、20、30日均线

且30日均线在60日均线上方

且当日形成双神

则当日作为候选,该因子值为True,否则为False

:param df: 待计算扩展因子的DataFrame

:return: 包含扩展因子的DataFrame

"""

# 均线周期列表

ma_list = [5, 10, 20, 30, 60]

# 计算均线的因子,保存到临时的DataFrame中

temp_df = mas(df, ma_list)

# 计算穿多线的因子,保存到临时的DataFrame中

temp_df = cross_mas(temp_df, ma_list)

# 穿多线因子的列名列表

column_list = ['cross_{}'.format(x) for x in ma_list[:-1]]

# 计算是否为候选

df['candidate'] = temp_df[column_list].all(axis=1) & (temp_df['ma_30'] >= temp_df['ma_60']) & df['ss']

return df

if __name__ == '__main__':

stock_codes = get_stock_codes()

create_data_mp(stock_codes)

博客内容只用于交流学习,不构成投资建议,盈亏自负!

欢迎大家转发、留言。已建微信群用于学习交流,群1已满,群2已创建,感兴趣的读者请扫码加微信!

如果认为博客对您有帮助,可以扫码进行捐赠,感谢!

| 微信二维码 | 微信捐赠二维码 |

|---|---|

|

|

运行了脚本 数据库没有出现怎么回事?

有点奇怪,好几位都有这个问题。我换了一台电脑,可以正常运行。您试下在代码里加一些打印信息,定位下哪里出了问题?

你们可以运行吗?

好几位都不行,帮忙定位下问题吧,在代码里加一些打印信息,看看是哪里没正常执行

这个测试通过了

赞

出错了:

File “C:\Users\Administrator\AppData\Local\Programs\Python\Python38\lib\threading.py”, line 932, in _bootstrap_inner

self.run()

File “C:\Users\Administrator\AppData\Local\Programs\Python\Python38\lib\threading.py”, line 870, in run

self._target(*self._args, **self._kwargs)

File “C:\Users\Administrator\AppData\Local\Programs\Python\Python38\lib\multiprocessing\pool.py”, line 519, in _handle_workers

cls._wait_for_updates(current_sentinels, change_notifier)

File “C:\Users\Administrator\AppData\Local\Programs\Python\Python38\lib\multiprocessing\pool.py”, line 499, in _wait_for_updates

wait(sentinels, timeout=timeout)

File “C:\Users\Administrator\AppData\Local\Programs\Python\Python38\lib\multiprocessing\connection.py”, line 879, in wait

ready_handles = _exhaustive_wait(waithandle_to_obj.keys(), timeout)

File “C:\Users\Administrator\AppData\Local\Programs\Python\Python38\lib\multiprocessing\connection.py”, line 811, in _exhaustive_wait

res = _winapi.WaitForMultipleObjects(L, False, timeout)

ValueError: need at most 63 handles, got a sequence of length 63

找到一个原因了,是不能超过60个进程。但是不知道怎样解决。

在 Python 3.8 中,concurrent.futures.ProcessPoolExecutor已更新以将能够在 Windows 上使用的工人(进程)的最大数量限制为 61。有关原因,请参阅this和this,但据我了解:

在 Windows 上,multiprocessing调用 Windows API 函数WaitForMultipleObjects,该函数用于等待进程完成。它最多可以等待 63 个对象,减去结果队列读取器和线程唤醒读取器,因此有 61 个限制。(即 Windows 每个进程使用一个线程来跟踪进程)。

是一个很好的问题。查看代码,这似乎是一个不可恢复的错误。但在我看来难以理解的是,ThreadPoolExecutor在 Windows 下会有代码将池大小限制为 61,而不是对multiprocessing.Pool类强制执行。无论如何,使用以下程序进行检查应该很容易。如果没有打印完成!并挂起,我会说肯定有问题,如果您正在使用,您应该明确限制池大小multiprocessing.Pool:

import multiprocessing

def worker(x):

return x ** 2

def main():

pool = multiprocessing.Pool(96)

results = pool.map(worker, range(96))

assert len(results) == 96

pool.close()

pool.join()

print(‘Done!’)

if __name__ == ‘__main__’:

main()

但是你的程序挂起的事实是相当确定的,上面的程序将挂起,我怀疑你甚至不会得到assert语句。无论哪种方式,使用大于 61 的池大小都不可靠。

运行前,别忘了手动pip install pymysql